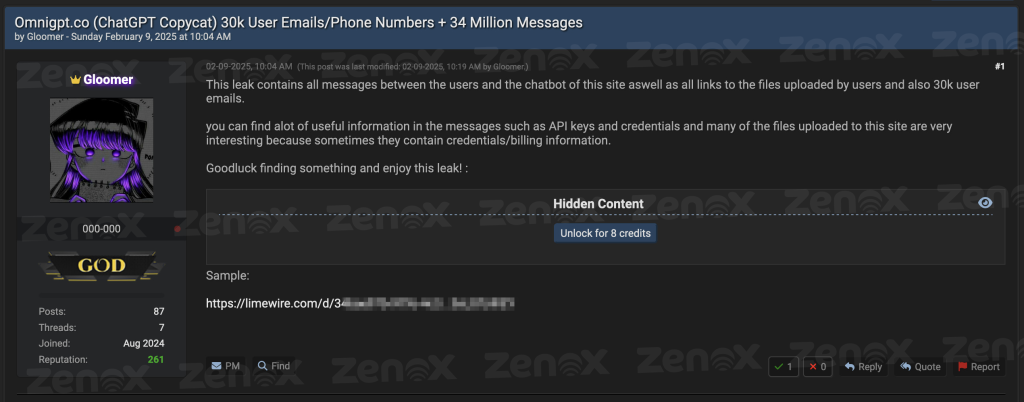

Na última segunda-feira (09/02), um usuário do BreachForums identificado como “Gloomer” publicou uma reivindicação de ter comprometido o OmniGPT, um agregador de Inteligência Artificial (IA) amplamente utilizado que fornece acesso a diversos modelos, incluindo ChatGPT-4, Claude 3.5, Gemini e Midjourney.

O ator malicioso afirma ter obtido aproximadamente 30 mil endereços de e-mail, números de telefone de usuários e mais de 34 milhões de linhas de conversas, além de todos os links para os arquivos enviados pelos usuários na plataforma. Uma amostra do conjunto de dados vazados foi disponibilizada na própria postagem.

O material completo do vazamento está disponível publicamente no BreachForums, podendo ser acessado mediante 8 créditos — uma unidade de troca interna do fórum, utilizada pelos participantes para adquirir materiais vazados e outros conteúdos restritos.

Estrutura do Vazamento

A equipe de Threat Intelligence da ZenoX conduziu uma investigação minuciosa do material vazado. O pacote inicial consistia em um arquivo ZIP de 534 MB que, quando descompactado, revelava um conjunto de dados de aproximadamente 1,8 GB distribuídos em quatro arquivos distintos. O arquivo “Files.txt” continha todas as URLs dos arquivos enviados pelos usuários à plataforma, potencialmente expondo documentos confidenciais, códigos proprietários e outros materiais sensíveis. O arquivo “messages.txt”, o mais volumoso do conjunto, apresentava mais de 34 milhões de linhas de conversas entre usuários e os diversos modelos de IA, contendo informações potencialmente sensíveis.

Os dois arquivos restantes continham informações pessoais dos usuários, incluindo endereços de e-mail, identificadores únicos e números de telefone, criando um catálogo completo que poderia ser utilizado para ataques direcionados ou campanhas de engenharia social.

Análise Técnica

Para compreender a extensão e as implicações do vazamento, a análise do material vazado foi separada em duas partes. Um script desenvolvido em Golang incorporou as duas abordagens, cada uma com suas próprias limitações e desafios técnicos.

1. Detecção de Credenciais

A primeira etapa da análise concentrou-se na identificação de possíveis credenciais e tokens de acesso. Foi utilizada uma lista contendo 87 padrões de expressões regulares (RegEx), incluindo chaves da AWS, tokens de acesso ao GitHub, Stripe e outras credenciais usadas em desenvolvimento de software. A análise resultou na identificação de diversos tipos de credenciais, com destaque para:

- 206 tokens do Hugging Face, potencialmente permitindo acesso a modelos proprietários de machine learning e dados de treinamento. A alta incidência sugere uso significativo da plataforma para desenvolvimento de IA.

- 369 tokens JWT, apresentando risco elevado devido à natureza das informações que podem conter e seu potencial uso para autenticação em sistemas diversos.

- No ambiente cloud, identificamos 38 chaves AWS Access Key e 46 contas de serviço Google Cloud Platform. A presença destas credenciais é particularmente preocupante devido ao amplo acesso que podem proporcionar a recursos críticos de infraestrutura.

- 28 chaves Stripe (14 públicas, 14 secretas) foram encontradas, indicando exposição de sistemas de pagamento e processamento financeiro.

| Tipo de Credencial | Quantidade |

| JWT token | 369 |

| Hugging Face Access Token | 206 |

| Google (GCP) Service-account | 46 |

| AWS Access Key ID | 38 |

| Stripe Publishable Key | 25 |

| Discord client secret | 15 |

| AWS Secret Access Key | 14 |

| Shopify token | 14 |

| Stripe Secret Key | 14 |

| Asymmetric Private Key | 13 |

| GitLab Personal Access Token | 11 |

| GitHub Personal Access Token | 3 |

| GitHub Fine-grained PAT | 2 |

| SendGrid API token | 2 |

| Slack Webhook | 1 |

| Adobe Client ID | 1 |

2. Análise Setorial

A segunda etapa focou na análise setorial do vazamento, utilizando como base as 1000 maiores empresas brasileiras para mapear o impacto em diferentes segmentos de mercado. Após uma busca simples por strings, foram detectadas 232 mil referências a organizações presentes no ranking. Essa abordagem foi escolhida por sua simplicidade e eficiência operacional, evitando a implementação de técnicas mais complexas como Named Entity Recognition (NER) e métodos avançados de processamento de linguagem natural (NLP). Embora essas técnicas pudessem trazer maior precisão, a decisão de não utilizá-las foi baseada em uma estratégia de agilidade na análise inicial.

O uso de técnicas de NER, por exemplo, poderia diferenciar o nome de empresa e seu uso como adjetivo comum, ou identificar menções indiretas e referências contextuais a organizações. No entanto, a análise optou por um algoritmo mais direto, priorizando a aplicação rápida, com ajustes e refinamentos realizados em etapas posteriores.

Para reduzir a ocorrência de falsos positivos e refinar os resultados, aplicou-se uma técnica de filtragem semântica e contextual com base nos seguintes critérios:

- Nomes Genéricos ou Comuns: Empresas cujo nome representa termos amplamente utilizados no vocabulário cotidiano ou palavras que frequentemente aparecem fora do contexto empresarial.

- Siglas Curtas ou Ambíguas: Empresas identificadas por siglas de duas ou três letras que poderiam ser confundidas com outras abreviações técnicas ou expressões comuns.

- Palavras Polissêmicas: Empresas com nomes que possuem múltiplos significados em diferentes contextos, frequentemente usados para designar níveis de experiência ou características genéricas.

Após esse processo de filtragem, o número de menções foi reduzido de 232 mil para 16 mil, destacando aquelas com alta probabilidade de serem referências corporativas legítimas. Esse ajuste garantiu que a análise final focasse em informações mais relevantes e confiáveis, preservando a eficiência da abordagem inicial sem comprometer a precisão dos resultados.

A análise setorial revelou padrões interessantes sobre o uso corporativo de ferramentas de IA. O setor de Seguros liderou com 2.139 menções, seguido pelo setor Farmacêutico e de Beleza com 1.886 referências. O segmento de Transporte e Logística apareceu em terceiro lugar com 1.755 menções, seguido por Alimentos e Bebidas com 1.549 citações. O setor Financeiro, combinando Bancos e Serviços Financeiros diversos, totalizou cerca de 2.938 menções, demonstrando forte dependência dessas tecnologias.

| Setor | Total de Menções |

| Seguradoras | 2139 |

| Farmacêutico e Beleza | 1886 |

| Transporte, Logística e Serviços Logísticos | 1755 |

| Alimentos e Bebidas | 1549 |

| Bancos | 1476 |

| Serviços Financeiros | 1462 |

| Educação | 1021 |

| Agronegócio | 837 |

| Atacado e Varejo | 657 |

| Petróleo e Químico | 657 |

| Bens de Capital e Eletroeletrônicos | 604 |

| Saúde e Serviços de Saúde | 462 |

| Cooperativas | 438 |

| Siderurgia, Mineração e Metalurgia | 389 |

| Moda e Vestuário | 317 |

| Participações e Mídia | 285 |

| Tecnologia e Telecomunicações | 254 |

| Energia | 169 |

| Imobiliário e Construção Civil | 140 |

| Papel e Celulose | 42 |

| Operadoras de Planos de Saúde | 33 |

| Saneamento e Meio Ambiente | 1 |

Essa distribuição setorial sugere que o OmniGPT vem sendo utilizado extensivamente para diferentes propósitos corporativos, desde desenvolvimento de software e automação de processos até análise de dados e suporte ao cliente. A presença significativa de setores regulados, como seguros e serviços financeiros, levanta preocupações adicionais sobre conformidade e proteção de dados sensíveis.

Conclusão

Esses resultados reforçam como o uso de soluções de IA está presente em múltiplos segmentos de negócio, mas também expõem fragilidades na maneira como dados corporativos são tratados. Cada vez mais, equipes de desenvolvimento e áreas de inovação aproveitam a produtividade oferecida por modelos avançados, mas, em contrapartida, é fundamental adotar boas práticas de segurança. Não se trata de evitar o uso de IA, e sim de criar processos que reduzam o risco de vazamentos — por exemplo, mascarando tokens e chaves verdadeiras antes de enviar trechos de código a qualquer modelo ou plataforma de assistência.

O incidente do OmniGPT serve como um alerta crucial sobre os riscos inerentes à adoção de ferramentas de IA sem controles adequados de segurança. Embora essas tecnologias ofereçam benefícios inquestionáveis em termos de produtividade e inovação, é essencial estabelecer um equilíbrio entre agilidade e proteção de dados.

O volume e a natureza das informações expostas demonstram que o uso corporativo de IA precisa ser acompanhado por uma estratégia robusta de segurança. Isso inclui não apenas medidas técnicas de proteção, mas também uma mudança cultural em direção a práticas mais seguras de compartilhamento de informações.

À medida que a adoção de IA continua a crescer, incidentes como este provavelmente se tornarão mais comuns. A capacidade das organizações de proteger seus dados enquanto aproveitam os benefícios dessas tecnologias será um diferencial competitivo crucial nos próximos anos. O caso OmniGPT não deve ser visto apenas como um incidente isolado, mas como um catalisador para uma discussão mais ampla sobre segurança e governança no uso corporativo de inteligência artificial.